Lernplattform dataX Academy gewinnt Sonderpreis für “Digitale Bildung”

Sponsored Post

Big Data ist die Zukunft, doch den meisten Unternehmen fehlen ausgebildete Datenexperten. Die Berliner Gründer Leo Marose und Stefan Berntheisel haben eine Lernplattform entwickelt, die Datenkompetenz auf eine völlig neue Art und Weise vermitteln soll – interaktiv und am Beispiel realistischer Szenarien. Für ihr Konzept werden sie jetzt vom Bundeswirtschaftsministerium auf der CeBIT 2017 mit dem Sonderpreis für “Digitale Bildung” ausgezeichnet.

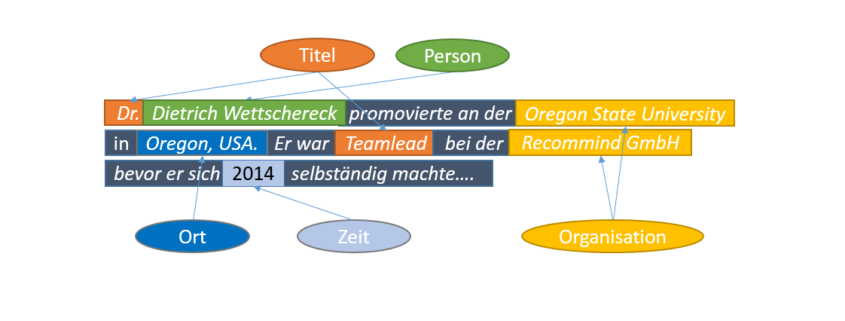

Der Bedarf an Experten für Themen wie Big Data, Machine Learning und künstlicher Intelligenz wächst rasant, das Angebot für Weiterbildungen ist aber immer noch gering. “Unternehmen sammeln immer mehr Daten, um wettbewerbsfähig zu sein – wissen aber oft nichts damit anzufangen”, erinnert sich der ehemalige Strategie-Berater Leo Marose. “Wir haben schnell gemerkt, dass hier ein riesiger Markt schlummert”. Gemeinsam mit dem IT-Systemarchitekten Stefan Berntheisel startet er 2016 dataX Academy. Die Idee: Angehende Data Scientists und Data Engineers sollen den Umgang mit komplexen Datensätzen nicht nur wie bislang in der Theorie, sondern auch in der Praxis lernen. Dazu stellt dataX Academy Online-Kurse mit echten Datensets und einer eigenen Programmierumgebung zur Verfügung. “Die Nutzer lösen dann realistische Übungsaufgaben, z. B. müssen sie herausfinden, an welchen Orten in New York mit der höchsten Taxi-Nachfrage zu rechnen ist. Allein für diese Aufgabe stehen mehr als 1,1 Milliarden echte Datenpunkte zur Verfügung”, erklärt Stefan Berntheisel. Andere Aufgaben stammen aus Bereichen wie Marketing, Geografie oder Logistik. Die Kurse werden gemeinsam mit Experten entwickelt und die Teilnehmer durch realistische Aufgaben und Probleme besser an die Praxis herangeführt. “Wir stellen immer die gesamte technische Infrastruktur für die Lernumgebung”, sagt Stefan Berntheisel und fügt hinzu: “So können Firmen ihre Mitarbeiter z. B. in Data Science sehr kostengünstig weiterbilden.” Die Kurse kosten zwischen 79 und 300 Euro. Mit dem Konzept gewann das Duo zuletzt den Startup-Award auf der Learntec 2017, der größten Messe für digitales Lernen in Europa, und erhielt eine EXIST-Förderung in Höhe von 125.000 Euro von der FU Berlin. Auf der diesjährigen CeBIT wird dataX Academy nun vom Bundeswirtschaftsministerium mit dem Sonderpreis für “Digitale Bildung” ausgezeichnet und erhält ein Preisgeld in Höhe von 10.000 Euro.

dataX Academy arbeitet aktuell an einer Finanzierungsrunde

– denn der Markt für Big Data wächst bis 2020 auf 61 Milliarden Dollar

Wenige Monate nach der Idee zu dataX Academy starteten Leo Marose und Stefan Berntheisel im Sommer 2016 einen ersten Produkttest in Indien, Europa und den USA – mit Erfolg. “Unsere Tests liefen sehr vielversprechend. Aktuell liegen unsere Akquisitionskosten pro Nutzer bei durchschnittlich einem Dollar. Deshalb arbeiten wir jetzt an einer weiteren Finanzierung, um unser Wachstum weiter zu beschleunigen”, sagt Leo Marose. Schon 2020 ist der Wachstumsmarkt Big Data über 61 Milliarden Dollar schwer, Experten schätzen das jährliche Wachstum auf satte 30 Prozent. Zwar gibt es bereits große E-Learning-Player am Markt mit vielseitigem Angebot, diese seien oft aber “nur in wenigen Bereichen spezialisiert und setzen vor allem auf Lernvideos oder Multiple-Choice-Tests”, so Stefan Berntheisel. “Der Bedarf ist riesig – allein in den USA fehlen über 500.000 Experten für Data Science, Data Engineering und Co. In Deutschland sind Datenexperten aktuell sogar noch schwieriger zu finden.” Deshalb rollt dataX Academy seine Lernplattform aktuell in Deutschland aus. Große Marken wie Daimler, Audi, Siemens und die Boston Consulting Group haben bereits Interesse angemeldet.

Über die dataX Academy

Das Berliner Startup dataX Academy trainiert die Datenexperten von Morgen. Mit der Plattform können Nutzer den Umgang mit “Big Data” nicht nur in der Theorie, sondern auch in der Praxis lernen. Dazu stellt dataX Online-Kurse mit echten Datensets und einer eigenen Programmierumgebung Verfügung. Die Kurse werden gemeinsam mit Experten entwickelt und die angehenden Data Scientists sowie Data Engineers durch realistische Aufgaben und Probleme besser an die Praxis herangeführt. So können Unternehmen oder Forschungseinrichtungen ihre Mitarbeiter kostengünstig weiterbilden.

Hinter der Idee stecken die Berliner Unternehmer Leo Marose und Stefan Berntheisel. Sie haben bereits zuvor das Online-Magazin BOXROX aufgebaut – mit monatlich einer Million Seitenaufrufe und internationalen Werbekunden wie Adidas, Reebok oder Nike. Zuletzt gewann dataX Academy den Startup-Award auf der Learntec, der größten Messe für digitales Lernen in Europa, und wurde vom Bundeswirtschaftsministerium mit dem Sonderpreis für “Digitale Bildung” auf der CeBit 2017 ausgezeichnet.

Pressekontakt

Leo Marose

Tel.: 0163 7788742

Mail: leo.marose@datax.academy

Web: www.datax.academy

Weitere Referenzen zu dataX Academy

- Gewinner des 1. Platz auf der LearnTec 2017

https://www.learntec.de/website/f%C3%BCr-besucher/learntec-start-up-pitch/index.jsp - Gewinner des 1. Platz des Businessplan-Wettbewerb Berlin-Brandenburg

https://www.b-p-w.de/fileadmin/redakteur/bilder/BPW_2017/Steckbriefe/BPWCanvas-Steckbrief-Platzierung-dataX.pdf - Weiterführende Informationen zum Sonderpreis “Digitale Bildung”

http://www.gruenderwettbewerb.de/wettbewerb/runde-2016-1/sonderpreis-digitale-bildung