5 Best Practices for Performing Data Backup and Recovery

Data backup and recovery are critical for any organization in the digital age. The field of data science has developed advanced, secure, user-friendly backup and recovery technology over recent years. For anyone new to data backup and recovery, it can be challenging knowing where to start, especially when dealing with large quantities of data. There are some best practices in data backup and recovery that are beneficial for any user or organization. These tips will provide a jumping-off point for creating a customized data protection strategy.

1. Create a Frequent Backup Plan

One of the first steps to protecting data from loss is creating a plan or schedule for backups. Frequency is key for a quality backup schedule. Creating data backups only once or twice a year increases the risk of losing data in the intervening months between backups. The exact frequency will depend on individual circumstances to a certain extent, specifically the frequency with which new data is being created.

For individuals, weekly backups are recommended for devices like personal computers. Businesses and organizations have significantly more data to manage than individuals do. This means that more data has to be included in each backup, new data is created faster, and data storage is more expensive.

After deciding on the timing of the backups, consider what the best way to execute them is. For more frequent backups, automation may be a good idea. Automated backups dodge the risk of anyone forgetting to initiate the backup and make it easier to manage large backups.

2. Vary Backup Locations and Media

One of the most common data backup and recovery tips is the 3-2-1 rule. This data backup strategy suggests keeping three backups of important files with two copies backed up in two distinct storage types and one copy backed up off-site.

The idea behind the 3-2-1 approach is to build resilience through redundancy and variation. Even if a hacker is able to access an on-site hard drive of sensitive data, they won’t be able to damage the isolated off-site copy of that data.

The 3-2-1 rule is simply a starting point for data storage methods. Individuals and organizations should carefully consider what backup and recovery media best suits their specific needs. The cloud might be ideal for one business’s data storage, while independent drives might be better for another. The key is to have some measure of variation in the types of backup media and where they are stored. You could use an offsite server, the cloud, or any other combination of backup storage options. Keeping at least one copy in a unique location is wise, though. In the event of a natural disaster, for example, this could be critical to recovering data lost on-site.

3. Plan for Extensive Data Storage

This next tip is especially important for organizations or individuals backing up large amounts of data. From the start, it is a good idea to plan for extensive storage needs. The cost of data storage may seem intimidating, but it is often better to face it up front and consider how much data storage will be needed in the long term.

You might start out using only a partition of cloud storage and a smaller backup server. Have a plan in mind for how you will expand your storage space as time goes on. Different niches and industries have different data storage needs. For example, organizations in the ad tech industry will need bulk data storage for app tracking data and media. This data can pile up rapidly, so a bulk storage plan is critical for a data backup and recovery strategy.

4. Regularly Test Backup and Recovery Measures

A crucial component of any data backup and recovery strategy is a schedule for testing the strategy. In the event that a recovery is needed, it will be extremely helpful for key team members to know how to proceed. Knowing that the recovery tactics in place have been tested recently offers some peace of mind, as well.

There are countless ways to test data backup and recovery strategies. Simulations are a popular method. For example, a data scientist could use an AI or white-hat hacker to conduct a simulated cyberattack on the data then run a recovery of that data afterward. Before running a test simulation, it is a good idea to backup data and ensure that no data is genuinely at risk of being lost, just in case the recovery strategy has unforeseen weaknesses.

5. Budget for Security

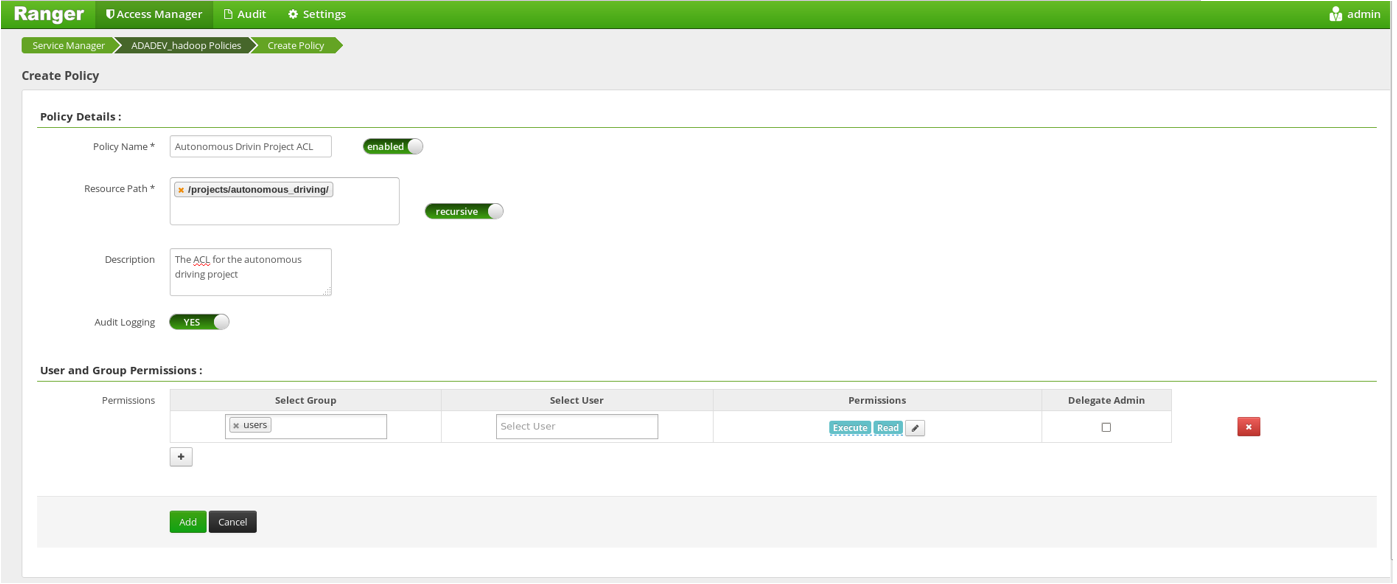

One of the main goals of creating a data backup and recovery plan is protecting data from cyberattacks. So, it is important to make sure that the backup and recovery methods being used are secure. There are layers to this security, as well. For example, an organization might choose to back up some of its data in the cloud. Their first line of defense is the security of their cloud storage provider. The next line of defense then might be encryption on the organization’s files or documents stored with that cloud provider.

Security measures vary from case to case. A general rule of thumb, however, is to invest in the best security possible. Take the time to research the defenses of data storage providers before choosing one to partner with. Make sure on-site cybersecurity is resilient and up-to-date. Encrypt anything particularly sensitive, just in case. Cybersecurity is an investment, but budgeting for it may be the difference between recovering data and losing it.

Resilient Data Backup and Recovery

These best practices for performing a successful data backup and recovery will help get you started. The next step is to conduct thorough research on your personal or organizational data protection needs. The goal is to find a balance between budget and performance, where you are getting the most secure data storage possible at the best value.