Was ist eigentlich der Beruf des Quants? Vergleich zum Data Scientist.

Quants kennt man aus Filmen wie Margin Call, The Hummingbird Project oder The Big Short. Als coole Typen oder introvertierte Nerds dargestellt, geht es in diesen Filmen im Kern um sogenannte Quantitative Analysts, oder kurz Quants, die entweder die großen Trading Deals abschließen oder Bankenpleiten früher als alle anderen Marktteilnehmer erkennen, stets mit Computern und Datenzugriffen ausgestattet, werfen Sie tiefe Blicke in die Datenbestände von Finanzinstituten und Märken, das alles unter Einsatz von Finanzmathematik.

Quants sind in diesen und anderen Filmen (eine Liste für das persönliche Abendprogramm füge ich unten hinzu) die Helden, manchmal auch die Gangster oder eine Mischung aus beiden. Den Hackern nicht unähnlich, scheinen sie in Filmen geradezu über Super-Kräfte zu verfügen, dem normalen Menschen, ja sogar dem erfahrenen Banken-Manager gegenüber deutlich überlegen zu sein. Nicht von ungefähr daher auch “Quant”, denn die Kurzform gefällt mit der namentlichen Verwechslungsgefahr gegenüber der kaum verstandenen Quantenphysik, mit der hier jedoch kein realer Bezug besteht.

Auf Grundlage der Filme zu urteilen, scheint der Quant dem Data Scientist in seiner Methodik dem Data Scientist ebenbürtig zu sein, wenn auch mit wesentlich prominenterer Präsenz in Kinofilmen.

Kleiner Hinweis zu den Geschlechtern: Mit Quant, Analyst und Scientist sind stets beide biologische Geschlechter gemeint. In den Filmen scheinen diese nahezu ausschließlich männlich zu sein, in der Realität aber habe ich in etwa genauso viele weibliche wie männliche Quants und Data Scientists kennenlernen dürfen.

Was unterscheidet also einen Quant von einem Data Scientist?

Um es gleich vorweg zu nehmen: Gar nicht so viel, aber dann doch ganze Welten.

Während die Bezeichnung des Berufes Data Scientists bereits ausführlich erläutert wurde – siehe den Data Science Knowledge Stack – haben wir uns auf dieser Seite noch gar nicht mit dem Quantitative Analyst befasst, der ausgeschriebenen Bezeichnung des Quants. Vom Wortlaut der Berufsbezeichnung her betrachtet gehören Quants zu den Analysten oder genauer zu den Financial Analysts. Sie arbeiten oft in Banken oder auch Versicherungen. In letzteren arbeiten sie vor allem an Analysen rund um Versicherungs- und Liquiditätsrisiken. Auch andere Branchen wie der Handel oder die Energiebranche arbeiten mit Quantitativen Analysten, z. B. bei der Optimierung von Preisen und Mengen.

Aus den Filmen kennen wir Quants beinahe ausschließlich aus dem Investmentbanking und Risikomanagement, hier sind sie die Ersten, die Finanzschwierigkeiten aufdecken oder neue Handelschancen entdecken, auf die andere nicht kommen. Die Außenwahrnehmung ist denen der Hacker gar nicht so unähnlich, tatsächlich haben sie auch Berührungspunkte (nicht aber Überlappungen in ihren Arbeitsbereichen) zumindest mit forensischen Analysten, wenn es um die Aufdeckung von Finanzskandalen bzw. dolose Handlungen (z. B. Bilanzmanipulation, Geldwäsche oder Unterschlagung) geht. Auch bei Wirtschaftsprüfungsgesellschaften arbeiten Quants, sind dort jedoch eher als Consultants für Audit oder Forensik bezeichnet. Diese setzen ebenfalls vermehrt auf Data Science Methoden.

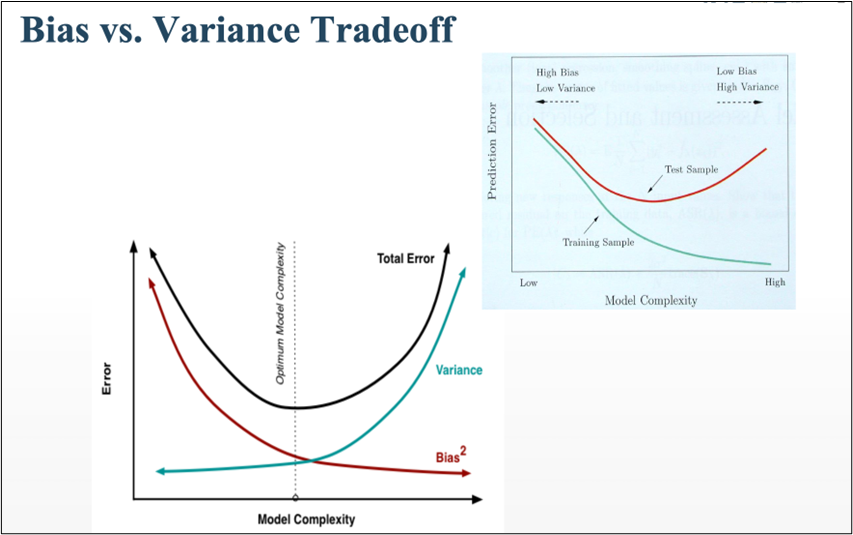

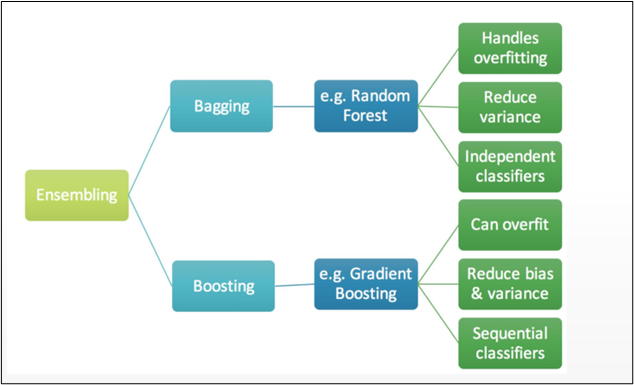

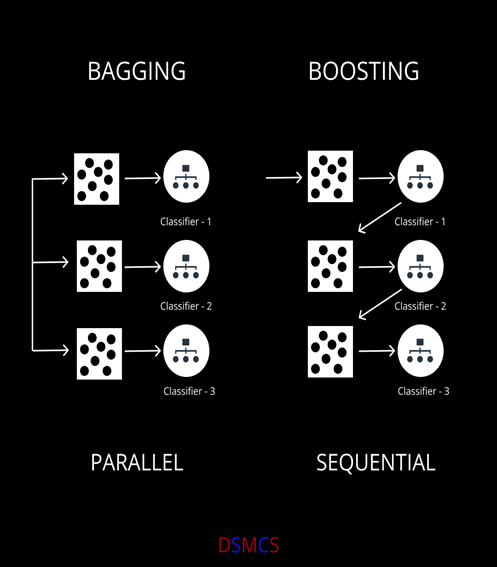

In ihrer Methodik sind sie sowohl in Filmen als auch in der Realität der Data Science nicht weit entfernt, so analysieren Sie Daten oft direkt auf der Datenbank oder in ihrem eigenen Analysesystem in einer Programmiersprache wie R oder Python. Sie nutzen dabei die Kunst der Datenzusammenführung und -Visualisierung, arbeiten auf sehr granularen Daten, filtern diese entsprechend ihres Analysezieles, um diese zu einer Gesamtaussage z. B. über die Liquiditätssituation des Unternehmens zu verdichten. Im Investmentbanking nutzen Quants auch Methoden aus der Statistik und des maschinellen Lernens. Sie vergleichen Daten nach statistischen Verteilungen und setzen auf Forecasting-Algorithmen zur Optimierung von Handelsstrategien, bis hin zum Algorithmic Trading.

Quants arbeiten, je nach Situation und Erfahrungsstufe, auch mit den Methoden aus der Data Science. Ein Quant kann folglich ein Data Scientist sein, ist es jedoch nicht zwingend. Ein Data Scientist ist heutzutage darüber hinaus jedoch ein genereller Experte für Statistik und maschinelles Lernen und kann dies nahezu branchenunabhängig einbringen. Andererseits spezialisieren sich Data Scientists mehr und mehr auf unterschiedliche Themenbereiche, z. B. NLP, Computer Vision, Maschinen-Sensordaten oder Finanz-Forecasts, womit wir bei letzterem wieder bei der quantitativen Finanz-Analyse angelangt sind. Die Data Science tendiert darüber hinaus jedoch dazu, sich nahe an die Datenbereitstellung (Data Engineering) – auch unstrukturierte Daten – sowie an die Modell-Bereitstellung (Deployment) anzuknüpfen (MLOp).

Fazit zum Vergleich beider Berufsbilder

Der Vergleich zwischen Quant und Data Scientist hinkt, denn beide Berufsbezeichnungen stehen nicht auf der gleichen Ebene, ein Quant kann auch ein Data Scientist sein, muss es jedoch nicht. Beim Quant handelt es sich, je nach Fähigkeit und Tätigkeitsbedarf, um einen Data Analyst oder Scientist, der insbesondere Finanzdaten auf Chancen und Risiken hin analysiert. Dies kann ich nahezu allen Branchen erfolgen, haben in Hollywood-Filmen ihre Präsenz dem Klischee entsprechend in einer Investmentbank und sind dort tiefer drin als alle anderes (was der Realität durchaus entsprechen kann).

Quants in Kino + TV

Lust auf abgehobene Inspiration aus Hollywood? Hier Liste an Filmen mit oder sogar über Quants [in eckigen Klammern das Kernthema des Films]:

- The Hummingbird Project (2018) [High Frequency Trading & Forensic Analysis]

- Money Monster (2016) [Drama, hat Bezug zu Algorithmic Trading]

- The Big Short (2015) [Finanzkrisen – Financial Risk Analysis]

- The Wall Street Code (2013) [Dokumentation über Algorithmic Trading]

- Limitless (2011) [nur kurze Szenen mit leichtem Bezug zu Financial Trading Analysis]

- Money and Speed: Inside the Black Box (2011) [Dokumentation zu Financial Analysis bzgl. des Flash Crash]

- Margin Call (2011) [Bankenkrise, Vorhersage dank Financial Risk Analysis]

- Too Big To Fail (2011) [Bankenkrise, Vorhersage dank Financial Risk Analysis]

- The Bank (2001) [Algorithmic Trading & Financial Risk Analysis]

Meine besondere Empfehlung ist “Margin Call” von 2011. Hier kommt die Bedeutung der Quants im Investment Banking besonders eindrucksvoll zur Geltung.

Data Scientists in Kino + TV

Data Scientists haben in Hollywood noch nicht ganz die Aufmerksamkeit des Quants bekommen, ein bisschen etwas gibt es aber auch hier zur Unterhaltung, ein Auszug:

- The Imitation Game (2014) [leichter Bezug zur Data Science, Entschlüsselung von Texten, leichter Hacking-Bezug]

- Moneyball (2011) [Erfolg im Baseball mit statistischen Analysen – echte Data Science!]

- 21 (2008) [reale Mathematik wird verwendet, etwas Game Theory und ein Hauch von Hacking]

- Clara – A Billion Stars (2018) [Nutzung von Datenanalysen zur Suche nach Planeten in der Astronomie]

- NUMB3RS (2005 – 2010) [Serie über die Aufklärung von Verbrechen mit Mathematik, oft mit Data Science]

Meine persönliche Empfehlung ist Moneyball von 2011. Hier wurde zum ersten Mal im Kino deutlich, dass Statistik kein Selbstzweck ist, sondern sogar bei Systemen (z. B. Spielen) mit hoher menschlicher Individualität richtige Vorhersagen treffen kann.