Mit den richtigen Prozessen zum Erfolg: vier Schritte zum Business-IT Alignment

Digitalisierung, Agilität, Tech-basiert: Sowohl in der IT-Transformation als auch im Business-Alignment stecken diese drei strategischen Schlagworte. Häufig sorgen sie jedoch nur für oberflächliche Veränderungen. Tatsächlich ist die Abstimmung von Business und IT für viele Unternehmen nach wie vor eine Herausforderung. Die Transformation ist schließlich keine einmalige Umstellung von A auf B, sondern ein dauerhafter Zustand der ständigen Veränderungen.

Stop processing the same mistakes! Four mistakes to business & IT alignment

Für ein erfolgreiches Business-IT Alignment benötigen Unternehmen vor allem adaptive Technologien. Nur so können sie mit den Entwicklungen in der Branche und dem zunehmend geforderten Kundenerlebnis auf Technologiebasis Schritt halten. Alignment bedeutet also, die bis dato als getrennt wahrgenommenen Bereiche Business und Technologie miteinander zu verbinden.

Von der Informations- zur Business-Technologie

Ob es um die Organisation von Geschäftsprozessen, die Kommunikation mit Kunden oder die Erbringung von Dienstleistungen geht: Informationstechnologie sorgt in all diesen Bereichen für Veränderungen. Dabei ist die Abstimmung von Business und IT für den Markteinfluss und das Wachstum mehr denn je von entscheidender Bedeutung. Auch wenn es keine vorherrschende Reorganisationsstrategie gibt, tendieren die meisten Unternehmen dazu, ihre IT zu dezentralisieren. Dadurch wird sie näher an die Endnutzer gebracht, die Wissensbasis verschmilzt zudem häufig mit der Geschäftsstrategie.

Bei dieser Taktik stehen die Geschäftsziele im Mittelpunkt: Die IT kann die Dynamik des Unternehmens schneller mit permanenten Lösungen unterstützen und aufrechterhalten. Technologischer Fortschritt und Verbesserungen werden wiederum in aktuelle und zukünftige Strategien und Initiativen integriert. Besonders erfolgreiche Unternehmen zeichnen sich dadurch aus, dass sie strenge Organisationsstrukturen hinter sich lassen – die traditionelle Frage „In welcher Abteilung arbeiten Sie?“ wird zu „Wie arbeiten Sie?“.

Aber wie beweist die IT ihren Wert und gewinnt das Vertrauen der C-Suite? Laut Gartner haben fast 20% der Unternehmen bereits in Tools investiert, mit denen geschäftsrelevante Kennzahlen überwacht werden können. Bis 2021 sollen es voraussichtlich 60% sein. Das Problem ist jedoch, dass viele I&O-Führungskräfte nicht wissen, wo sie ansetzen sollen, wenn sie eine IT-Überwachungsstrategie initiieren.

Vier Herausforderungen des Business-IT Alignments

CIOs stehen unter dem zunehmenden Druck, die wachsenden und sich verändernden digitalen Anforderungen zu erfüllen. Zugleich sollen sie auch die Betriebsumgebung mit neuen Funktionen ausstatten und nachweisen, dass die IT einer bestimmten Geschäftsstrategie entspricht. Unabhängig von der Größe eines Unternehmens gilt: Zukunftsorientierten Organisationen kann die Technologie konkrete Vorteile (wie Geschwindigkeit und Leistung) bieten, um operative und Umsatzziele effizient zu erreichen und die Innovationserwartungen ihrer Kunden zu erfüllen. Eine gute technologische Infrastruktur bereichert die Kultur, Effizienz und Kundenbeziehungen eines Unternehmens.

Von 0 auf 100: Business- und IT Alignment

Wer eine kontinuierliche Strategie implementiert, wird mit einer besser funktionierenden Organisation, mehr Gewinn und einem besseren ROI belohnt. Schließlich erreicht man seine Ziele mit weniger Aufwand und agiert dadurch effizienter. Natürlich gibt es keine Standardmethode für eine erfolgreiche Abstimmung. Eine Organisation, in der sich die IT- und Geschäftsstrategie im Einklang befindet, kann ihre Flexibilität und betriebliche Effizienz mit einer maßgeschneiderten Strategie deutlich verbessern. Dieser Kampf zwischen Effizienz und Effektivität war noch nie so entscheidend für das Überleben von Unternehmen wie heute.

In der Tat sind es vor allem erfolgreiche Unternehmen, die sich umfassend mit den Zusammenhängen zwischen IT und Business befassen und die Bedeutung dieser Synergie verstehen. Hervorragende Beispiele hierfür sind Amazon und Apple. Bei beiden Konzernen sind Technologie und technologische Innovation integraler Bestandteil der Betriebsstruktur. In einigen Fällen haben sie ihre Technologie- und Geschäftsstrategien sogar selbst entwickelt.

Konvergenz und Integration

Viele erfolgreiche Unternehmen haben die Effizienz ihrer Technologieinvestitionen gesteigert und die finanziellen und operativen Risiken, die mit geschäftlichen und technologischen Veränderungen einhergehen, erheblich reduziert.

Wenn das Tempo von Veränderungen und geschäftlicher Agilität derart hoch ist, muss man jedoch auch die Konvergenz und Integration einbeziehen und nicht nur die Abstimmung von IT und Business. Mit anderen Worten: Unternehmen müssen ihre Denkweise verändern und auf eine neue Ebene bringen, sodass sich alle Mitarbeiter auf die gemeinsame Schaffung von „echtem Mehrwert“ konzentrieren und schnell auf Kunden und Nutzer reagieren können.

Granulare Strategien

Fehlt eine granulare Strategie, können abweichende Abteilungsziele, Kulturen und Anreize dazu führen, dass Unternehmen zu viel Geld für Technologie ausgeben, ohne dadurch ihre geschäftlichen Herausforderungen zu lösen. Einfacher ausgedrückt: Beim Business-IT Alignment sollte die Technologie in die Strategie, Mission und Ziele eines Unternehmens integriert werden, um folgende Ziele zu erreichen:

- Schnellere Markteinführungszeit

- Höhere Rentabilität

- Besseres Kundenerlebnis

- Bessere Zusammenarbeit

- Mehr Unternehmens- und IT-Agilität

- Strategische, technologische Transformation

Hot Topic

| Sehen Sie sich die Webinaraufzeichnung Empowering Collaboration Between Business and IT mit Fabio Gammerino, Signavio Pre-Sales Consultant, an. |

Das Potenzial von Prozessen: vier Schritte zum optimalen Business-IT Alignment

Business-IT Alignment erscheint vielen Organisationen als intuitiver Prozess. Dennoch haben viele Unternehmen Schwierigkeiten, dieses hochgesteckte Ziel auch tatsächlich zu erreichen. Das liegt nicht nur daran, dass die Abstimmung von IT und Fachbereichen ein aufwendiger und langwieriger Prozess ist.

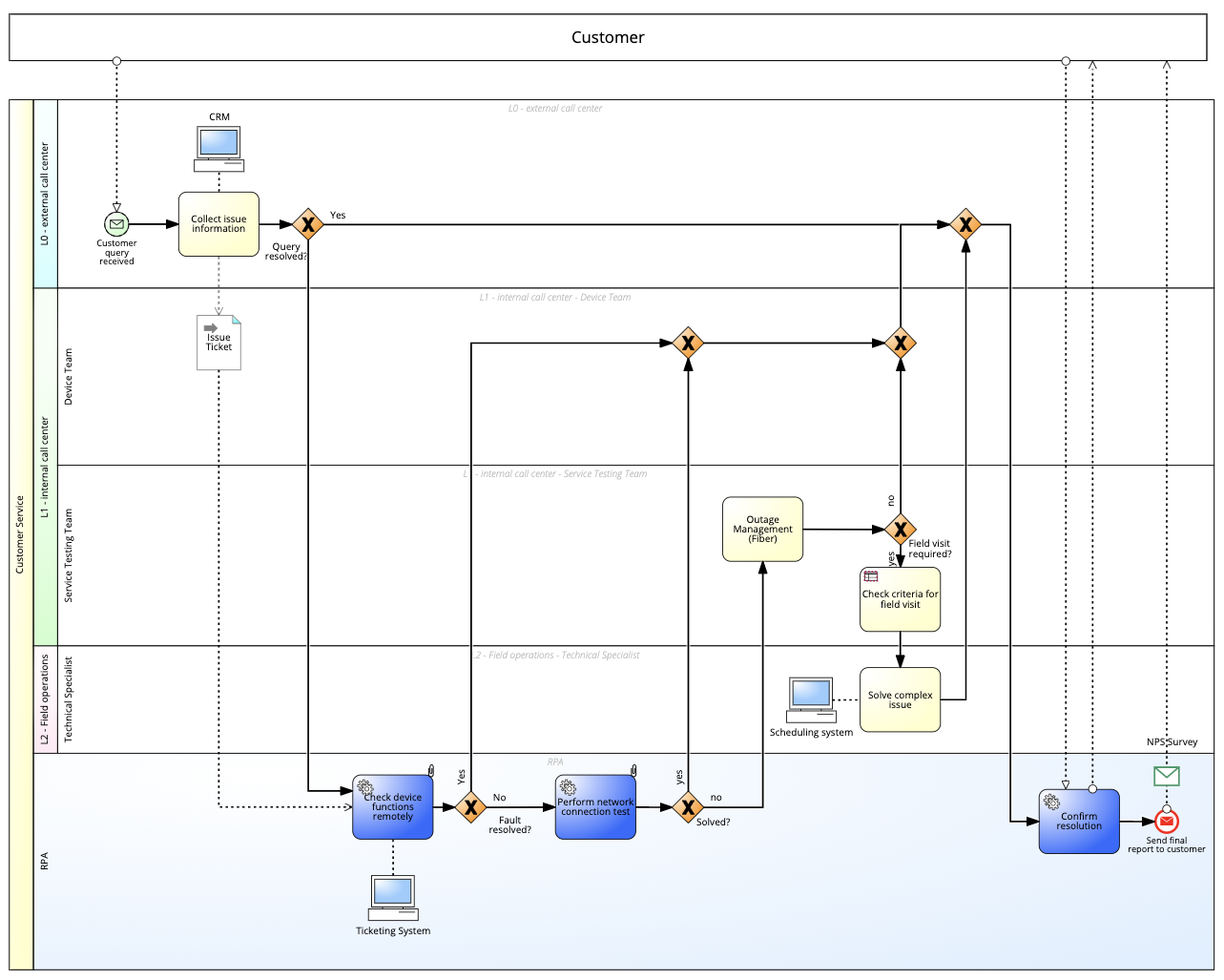

Darüber hinaus besteht der Gesamtprozess aus vielen kleineren Teilprozessen. Diese Teilprozesse haben keinen definitiven Start- und Endpunkt, sondern beinhalten einige Lern- und Umsetzungszyklen, die das Gesamtziel schrittweise vorantreiben. Sie sind also keine simplen Lösungen. Durch den Aufbau einer gemeinsamen Sprache und abteilungsübergreifender Beziehungen, die Gewährleistung von Transparenz und die Entwicklung präziser, unternehmensweiter Maßnahmepläne wird eine Brücke zwischen den beiden Bereichen geschaffen.

Vier Schritte zur optimalen Positionierung Ihrer Business-IT Alignment-Strategie:

- Planen: Wandeln Sie Geschäftsziele in messbare IT-Services um, sodass Ressourcen effektiv zur Verbesserung von Umsatz und ROI genutzt werde können – dieser Schritt erfordert eine kontinuierliche Kommunikation zwischen den Unternehmens- und IT-Verantwortlichen.

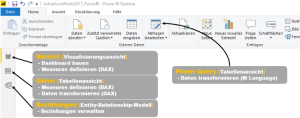

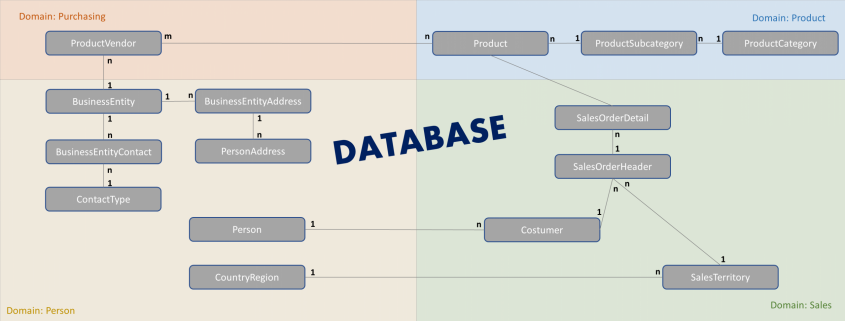

- Modellieren: Die IT-Abteilung entwirft eine Infrastruktur zur Optimierung und Verbesserung der geschäftlichen Prozesse. Die IT-Abteilung muss die geschäftlichen Anforderungen verstehen und sicherstellen, dass sie Systeme implementiert, die für das Unternehmen von entscheidender Bedeutung sind.

- Verwalten: Der Service erfolgt auf Basis der Unternehmensziele und -erwartungen. Die IT muss als zentraler Ansprechpartner für Serviceanfragen fungieren und auf diese Anfragen entsprechend der vordefinierten Prioritäten eingehen.

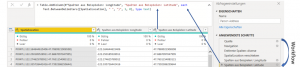

- Messen: Verbesserung der organisationsweiten Transparenz und der Service Level Commitments. Obgleich Kennzahlen von entscheidender Bedeutung sind, ist es weitaus wichtiger, dass die IT einen Geschäftskontext für die von ihnen gemessenen Daten und eine klare Beziehung zwischen den gemessenen Parametern und den Geschäftszielen sicherstellt.

Die Meinung von Signavio

| Die vorübergehende Rotation von IT-Mitarbeitern innerhalb des Unternehmens ist eine der Hauptstrategien für die Ausrichtung von Business und IT, da hierdurch internes Wissen im Unternehmen geteilt wird. Diese Wissensweitergabe sorgt für eine bessere Beziehung zwischen der IT-Abteilung und anderen Unternehmensbereichen und erweitert die Kompetenzen, insbesondere bei neuen Mitarbeitern. Profunde Kenntnisse geben der Organisation mehr Flexibilität, gut ausgebildete Mitarbeiter bei Bedarf in anderen Rollen einzusetzen. |

Kontaktieren Sie uns

Erfahren Sie, wie Signavio mit der Signavio Business Transformation Suite Ihr Unternehmen bei der IT-Transformation und operativen Exzellenz unterstützen kann.